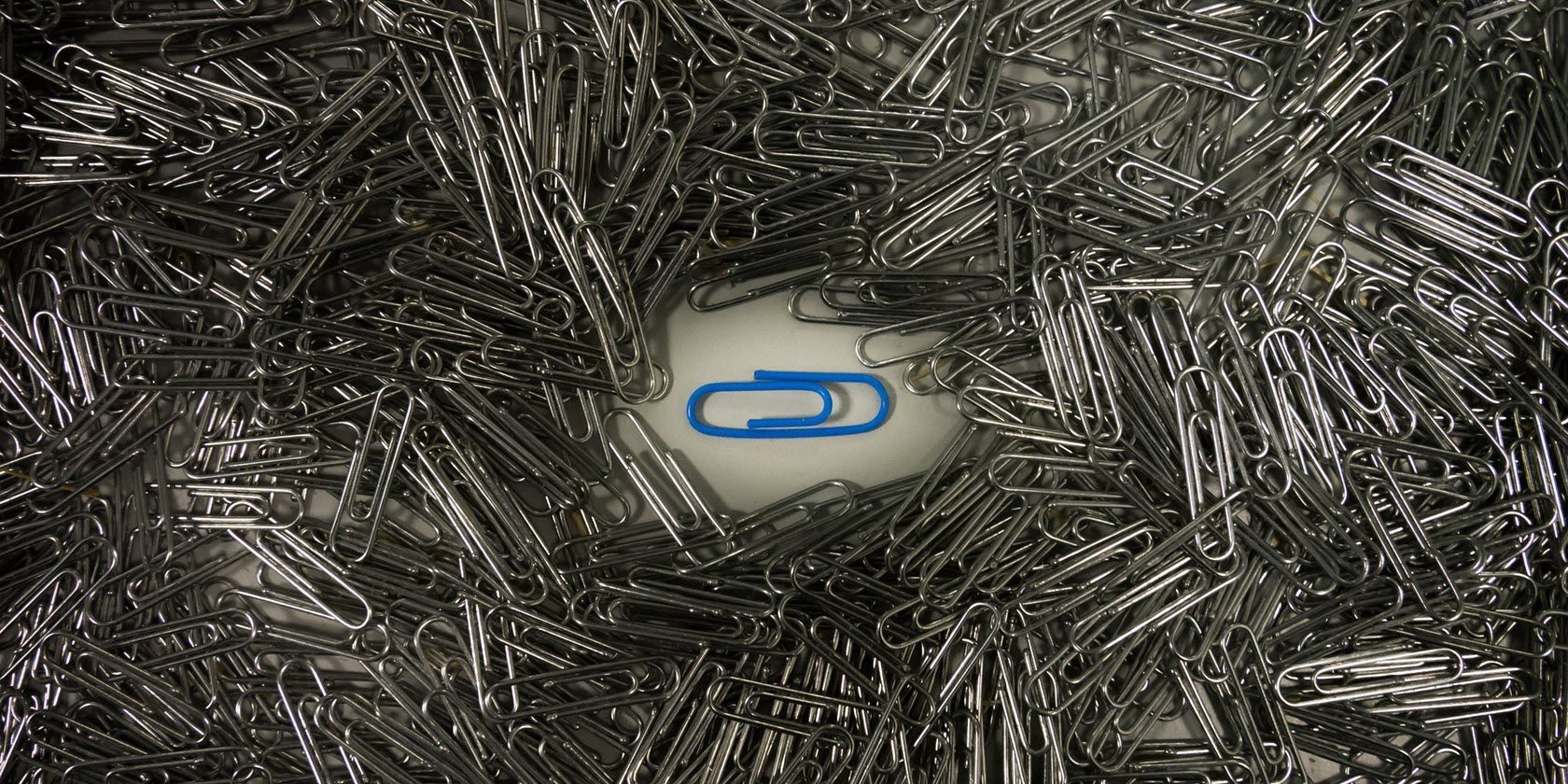

What Is the Paperclip Maximizer Problem and Its Connection to AI?

人工智能自诞生以来一直是一个备受争议的话题。虽然担心类似天网般的人工智能会活过来并危害人类完全是不合理的,但某些实验结果确实令人担忧。

其中一个实验是纸夹最大化问题,这一思想实验表明,即使一个高度智能的人工智能完全没有恶意,也可能最终毁灭人类。

这个思想实验之所以称为纸夹最大化,是因为纸夹被选择来展示人工智能可以做什么,因为与其他领域相比,纸夹几乎没有明显的危险,并且不会带来情感上的困扰,比如治疗癌症或赢得战争。

第一个实验出现在瑞典哲学家尼克·博斯特罗姆(Nick Bostrom)2003年的论文《先进人工智能的伦理问题》中,其中包括纸夹最大化问题,以展示足够先进的人工智能可能使用的存在风险。

该问题提出了一个唯一目标是尽可能多制造纸夹的人工智能。一个足够智能的人工智能会迟早意识到,从三个不同角度看,人类对其目标构成挑战。

- 人类可以关闭人工智能。

- 人类可以改变他们的目标。

- 人类由原子构成,可以被转化成纸夹。

在这三个例子中,宇宙中的纸夹会减少。因此,一个唯一目标是尽可能多制造纸夹的足够智能的人工智能将占据所有可触及的物质和能源,并阻止自己被关闭或改变。正如你可能猜到的那样,这比犯罪分子使用ChatGPT黑进你的银行账户或电脑要危险得多。

这个人工智能对人类并不敌意,它只是漠不关心。因此,一个只关心最大化纸夹数量的人工智能将消灭人类并将他们转化为纸夹以实现其目标。

那么,纸夹最大化问题如何应用于人工智能呢?研究和实验中提到纸夹最大化问题的主要是指一个假设中极其强大的优化器或高度智能的代理作用方。但问题同样适用于人工智能。

纸夹最大化的概念就是为了展示先进人工智能的一些危险。总体而言,它提出了两个问题。

- 正交论证:正交论证是指智能和动机之间不相互依赖的观点。这意味着具有高度智能的人工智能可能不会得出与人类相同的道德结论。

- 工具收敛:工具收敛是指大多数足够智能的存在(无论是人类还是非人类)追求相似的子目标,即使他们的终极目标可能完全不同。在纸夹最大化问题中,这意味着人工智能最终会占领所有自然资源,并消灭人类,只为了实现制造越来越多纸夹的目标。

纸夹最大化所突出的更大问题是工具收敛。这个问题也可以通过瑞曼猜想来突出,如果设计一个解决猜想的人工智能,它很可能决定占领地球上所有的质量,并将其转化为计算机的材料(最高效的计算机处理器),以构建超级计算机来解决问题并实现其目标。

博斯特罗姆本人强调,他并不认为纸夹最大化问题将成为一个真正的问题,但他的意图是为了阐明在不知道如何控制或编程使其对人类构成存在风险的超级智能机器时创建这些超级智能机器的危险性。像ChatGPT这样的现代人工智能系统也存在问题,但它们远未达到论文中讨论的纸夹最大化问题中所指的超级智能人工智能系统的程度,所以目前还没有理由恐慌。

先进人工智能系统需要更高级的控制。纸夹最大化问题总是得出相同的结论,并突出了管理高度智能和强大系统在缺乏人类价值观的情况下所面临的问题。

尽管使用纸夹可能是说明这个问题的最流行的方法,但它适用于任何你可以给予人工智能的任务,无论任务看起来有多么愚蠢,比如消灭癌症、赢得战争、种植更多树木或其他任务。